-

In memoriam: Arturo Muga

-

Violeta Pérez Manzano: «Si mi voz llega a una sola persona gitana y eso le inspira, ya habré cumplido»

-

In memoriam: German Gazteluiturri Fernández

-

Azúcar y edulcorantes ¿Qué debo saber?

-

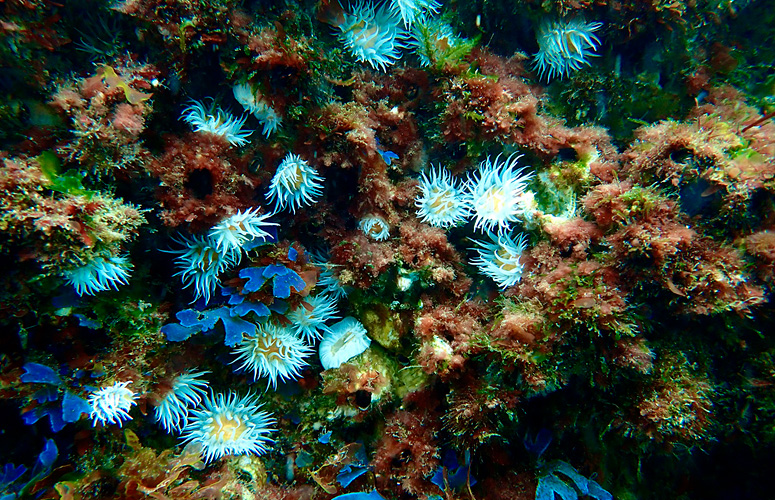

El aumento de la temperatura superficial del mar ha provocado profundas transformaciones en las comunidades de macroalgas

Olatz Arbelaitz Gallego

Adimen artifiziala eta joerak

Informatika Fakultateko irakaslea eta AldaPA ikerketa taldeko zuzendarikidea

- Cathedra

Fecha de primera publicación: 11/05/2023

Este artículo se publica en el idioma en que ha sido escrito.

Adimen Artifiziala (AA) bolo-bolo dabilen gaia da. Berri guztien artean zabalduenak Chat GPT4ren ingurukoak izan arren, badaude beste motetakoak ere. Lighthouse Reports eta El Confidencialek egindako ikerketa baten arabera Espainiako seguritate sozialak 2018. urtetik AA erabiltzen du laneko bajak kudeatu eta iruzurrak detektatzeko. Sistemaren erabilera ordea, ez omen da gardena, ez dute adierazten zein datu-mota erabili duten sistema entrenatzeko eta beraz, ezin dugu jakin algoritmo horrek joerarik ote duen edo azpitalderen bat diskriminatzen ote duen. Aurrean aipatutakoa adibide soila da baina sortu izan ditugun sistemak gehienetan opakuak, arautu gabeak eta inpugnatzeko zailak dira.

Hau guztia 2021ean Espainian argitaratu zen eskubide digitalen kartarekin kontrajarria dago. Bertan AAren gaineko eskubideak aipatzen dira:

1.- AAk pertsonan eta haren duintasunean zentratutakoa beharko du izan eta kalte ezaren printzipioa bete beharko du.

2.- AAko sistemen garapen eta bizi zikloan:

- a) Erabakiak, datuen erabilera eta AAn oinarritutako prozesuetan diskriminatua ez izateko eskubidea errespetatu beharko da, jatorria, arraza edo natura edozein dela.

- b) Gardentasun, auditagarritasun, azalpen eta trazabilitate baldintzak ezarriko dira. Baita giza ikuskapena eta gobernantza ere.

- c) Irisgarritasuna, erabilgarritasuna eta fidagarritasuna ziurtatu beharko dira.

3.- Pertsonek eskubidea dute giza gainbegirapena eta interbentzioa eskatzeko AAko sistemek berengan erabakiak hartzen dituztenean.

Gomendioak gomendio, alborapenen adibideak erraz topatzen dira. Bilatzaileak erabiltzen ditugunean, Google adibidez jendartean txertatutako rolak errepikatzen dira itzultzen dizkiguten irudietan. Zaharren zaintza (“taking care of elderly people”) bilatzen badugu, nabarmenki, lanean agertzen diren ia guztiak emakumeak dira. Bilaketak kirolarekin lotuak badaude aldiz, futbol jokalari (“football player”) bilatzen badugu adibidez, agertzen diren ia guztiak gizonezkoak dira. Itzultzaile automatikoak ere, ez daude salbu; enpresako zuzendaria gizonezko gisa hartuko dute haien itzulpenetan eta harreran egoten dena edo zaintzailea emakumezko gisa.

Pertsonon eguneroko bizitzan eragiten duten eta gure gaineko erabakiak hartzeko erabiltzen diren AAko sistemez inguratuta gauden heinean, garrantzitsua da sistema horiek alborapenik gabeak izatea. Aldiz, algoritmoek ez dituzte gauzak justuak egiten baizik eta populazio gero eta handiagoei eragiten dien berezko edozein alborapen handitzen dute.

Zergatik dituzte joerak AAko sistemek?

Sistema gehienek datuetatik edo adibideetatik lortzen dute ezagutza; oinarri matematikoa duten algoritmoak datuekin elikatzen dira ereduak sortzeko. Hasteko, datu-sorta handi bat beharko da adibide guztiak dagokien sailkapenarekin edo etiketarekin dituena. Gaixotasun bat iragartzeaz ari bagara adibidez, pazientearen datuak (neurketak, proben emaitzak, adina...) eta gaixotasuna ba ote duen ala ez (etiketa) izango ditugu. Algoritmoen helburua izango da sortutako ereduak ikasteko eman zaion datu-aleen sailkapenak ahalik eta ondoen egitea.

Eraikitako sistemen kalitatea aztertzeko, lagin osoaren parte bat gorde ohi da gero sistemak zenbatean asmatu duen aztertzeko; errendimendua sistemak iragarritakoa etiketa errealarekin konparatuta neurtzen da. Neurtuko duguna zera da, ereduak zein proportziotan asmatu dituen datu-aleen klaseak edo taldeak. Asmatze hori gordetako lagin osoarentzat edo klase bakoitzerako (gaixo/ez gaixo) neurtu izan dugu urteetan zehar baina ez dugu kontutan hartu azpitalde desberdinak ere badaudela: emakumezkoak, gizonezkoak, haurrak, beltzak, zuriak...

Aurreko azalpenetik erraz ondoriozta dezakegu sistemen joeren jatorria. Osasun arloan adibidez, EEBBetako armadako datuak erabili izan dira urteetan sistema adimendunak entrenatzeko. EEBBetako armadan %6 soilik dira emakumezkoak. Beraz, datu horiekin entrenatu eta baliozkotutako sistema batek gizonezkoentzat egindako iragarpenetan perfektu funtzionatzen badu, gutxienez %94ko asmatze-tasa izango du nahiz eta emakumezkoentzat egindako iragarpen guztiak okerrak izan. Ebaluatzerakoan azpi-talde ezberdinetarako duen portaerari erreparatzen ez badiogu, sistema oso eraginkorra dela pentsatzera irits gaitezke, joeraz jabetu gabe.

Nola gutxitu edo desagerrarazi joera horiek?

Ekimen asko daude arazo honi aurre egiteko. Adibidez Espainiako eskubide digitalen karta edo Europako erakundeen dokumentuak; Observatorio del Impacto Social y Ético de la Inteligencia Artificial (OdiseIA); The Institute for Ethical AI and Machine Learning; gaiaren inguruko bilkura zientifikoak edo enpresa handiek sortutako sail espezifikoak IBMko AI Fairness 360; Googleko Responsible AI practices; Microsofteko FATE...

Guri dagokigunean, maiz inguruko digitalizatutako datuak gogoetarik egin gabe erabili izan ditugu AAko sistemetan. Datuek, joerak izan ditzakete eta garrantzitsua da aztertzea haien jatorria zein den eta errealitatearen zein azpimultzori dagozkion. Era berean, datuak biltzeko prozesuak diseinatzean beharrezkoa izango da osatutako laginak errealitatea adieraztea eta, lantzen ari den gaian ager daitezkeen multzo desberdin guztietako adibideak jasotzea.

Bestalde, Ikasketa automatikoarekin sistemak sortzeko prozesuek gardenak izan behar dute, ereduak sortzeko kodea eskuragarri jarriz, edo eraikitze prozesua xehetasunez azalduz. Sortzen diren soluzioak interpretagarriak izateak ere lagunduko du.

Algoritmoen diseinu eta entrenamenduan tentagarria izan daiteke pentsatzea informazio sentsiblea duten aldagaiak, arraza, sexua, etab. sistematik ezabatzearekin joera desagertuko dela. Baina AAko sistemak hobeak dira gu baino datuen arteko erlazioak topatzen eta informazio hori ezabatu arren, auzunea, lana eta antzekoen arteko erlaziotik erator ditzakete generoa, arraza edo edozein aldagai sentsible. Beraz, soluzio sofistikatuagoak beharko dira.

Sistemen portaera estimatzeko erabiltzen diren metrikak kalkulatzean, azpimultzoak kontutan hartzen dituzten neurriak erabiltzea da aukera bat, baina hau ere ez da soluzio magikoa. “Parekotasun demografikoa” izeneko neurriak adibidez, bi taldeen gainean egindako aurreikuspen positiboen proportzioa berdintzea du helburu eta egokia izan liteke lan munduko joera historikoak aldatzeko. Emakume gehiago eraman nahi baditugu “mutilen klub” tipikoak osatutako lanpostu batera, hautapen prozesurako parekotasun demografikoa maximizatzen duen sistema bat erabiliz helburuak lor ditzakegu. Baina, neurri honek ez du talde bakoitzerako sailkapenaren kalitateari buruz ezer esaten eta medikuntza aplikazio batean adibidez, gizonezko gehiagok duten eritasun batekin ariko bagina, sistemak parekotasun demografikoa lor dezan saiatzeak ez luke zentzurik izango; gure sistemak gizon zein emakumeentzat eritasuna duten ala ez maila berean ongi iragartzea nahiko genuke eta horretarako beste neurri egoki bat topatu beharko genuke.

Dudarik ez da beraz, AAk gure egunerokoan eta jendartearen bizi-kalitatean sekulako eragina duela eta arrakalak are gehiago zabal ez daitezen, maila desberdinetan egin behar dela lan AA justuago eta gardenago baten alde.

Bibliografia

Castelnovo, A., Crupi, R., Greco, G., Regoli, D., Penco, I. G. & Cosentini, A.C. (2022).A clarification of the nuances in the fairness metrics landscape. Sci Rep 12, 4209. https://doi.org/10.1038/s41598-022-07939-1

Moncloa (2021). Carta de Derechos Digitales, https://www.lamoncloa.gob.es/presidente/actividades/Documents/2021/140721-Carta_Derechos_Digitales_RedEs.pdf (kontsulta, 2022, abendua)

O'Neil, C. (2017). Weapons of math destruction. Penguin Books.