-

Doce investigadoras de la UPV/EHU, entre las 500 más destacadas en el ránking del CSIC

-

Hablar puede salvar vidas

-

Estíbaliz Sáez de Cámara, nombrada presidenta de la REDS SDSN Spain

-

Se descubre el eslabón perdido en la historia de las lenguas indoeuropeas

-

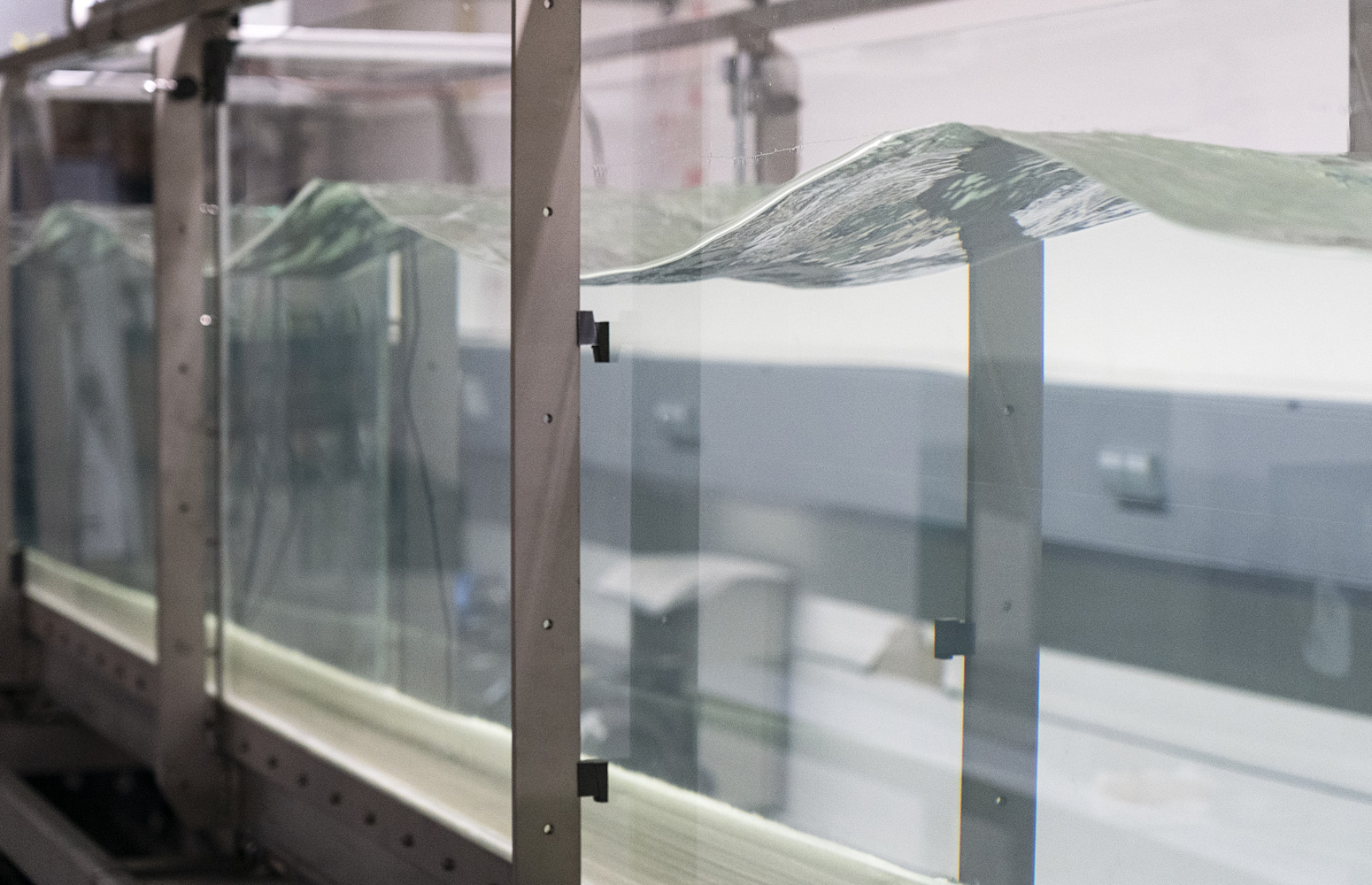

La Escuela de Ingeniería de Bilbao instala un canal de olas de 25 metros

Víctor Etxebarria Ecenarro

Inteligencia artificial, ¿abierta para todos o cerrada para beneficio de unos pocos?

Doctor en Ciencias Físicas y catedrático de Ingeniería de Sistemas y Automática. Facultad de Ciencia y Tecnología

- Cathedra

Fecha de primera publicación: 24/02/2025

(Abre una nueva ventana)

Este artículo se encuentra publicado originalmente en The Conversation.

A principios de los años ochenta mis padres trajeron a casa un ordenador doméstico conectado a la pantalla del televisor. Aquello me motivó para “jugar” a científico. Me enorgullecía publicar en aquellas primeras revistas de informática sencillos programas sobre cómo dibujar funciones matemáticas, monitorizar el código máquina del microprocesador o rudimentarias animaciones y juegos de ordenador.

Todo se publicaba incluyendo explicación detallada de cómo se realizaba el trabajo y el código fuente completo del programa, para que cualquiera pudiera copiarlo, probarlo, comprenderlo, reproducirlo y modificarlo fácilmente para cualquier propósito. Eso es la versión de ciencia abierta más elemental, concebida como empresa universal colectiva y acumulativa.

Los principios de la ciencia abierta

La ciencia abierta se refiere a la práctica de hacer que todas las etapas del proceso científico sean transparentes y accesibles para los demás. Eso incluye la publicación de artículos de investigación con sus datos, métodos detallados, bases teóricas y prácticas, experimentos, así como cualquier información o herramienta necesaria para poder repetir la investigación.

Los objetivos son permitir la reproducibilidad, fomentar la colaboración y facilitar la construcción sobre conocimientos previos para avanzar en el conocimiento. Eso es fundamental para que la investigación científica sea creíble, ética y accesible, y pueda revisarse, validarse y desarrollarse a partir de ella.

¿Qué ocurre con la IA?

Como en cualquier disciplina, la ciencia abierta en inteligencia artificial es la única manera de garantizar la reproducibilidad y la transparencia y, por tanto, su avance público y su uso coherente con principios colaborativos, acumulativos y en beneficio de la humanidad.

La gran mayoría de quienes se dedican a la investigación en ciencias de la computación cree en la publicación de sus avances siguiendo esos principios. El código abierto es uno de los elementos importantes -aunque no el único- de cualquier herramienta informática que quiera fomentar el avance científico.

Especialistas de esa área de conocimiento han ido creando diversas organizaciones sin ánimo de lucro para definir con precisión en qué consiste la investigación y el desarrollo en su ámbito.

Por ejemplo, en 1998, se fundó la Iniciativa para el código abierto (Open Source Initiative, OSI), y su definición de código abierto (open source) es el estándar internacional más aceptado.

Para que un programa se considere de código abierto no basta con facilitar el acceso al programa compilado, sino también a todo el código fuente. Tengamos en cuenta que ese último -también llamado lenguaje de alto nivel- es un programa escrito en un lenguaje de programación legible por una persona. Mientras, el código compilado -o lenguaje máquina- es una traducción del código fuente a un archivo binario que un circuito electrónico lo puede ejecutar, pero una persona no lo puede entender.

Otro requisito del código abierto es que permita su modificación y redistribución bajo esos mismos términos y para todos los usos, incluido el comercial.

El caso de las empresas tecnológicas

Existen muchas empresas que crean riqueza, benefician a la sociedad y también se benefician de la sociedad. Sin embargo, muy pocas invierten en investigación, a menos que crean que recuperarán la inversión.

Es común que las compañías tecnológicas privadas aprovechen la investigación pública (sufragada por el contribuyente) y la utilicen para desarrollar productos con los que obtienen grandes beneficios. La economista Mariana Mazzucato suele describir con detalle un ejemplo paradigmático: el caso del iPhone de Apple.

Con las empresas dedicadas a la inteligencia artificial, esa realidad es aún más llamativa. Puede ser natural basar sus productos en ideas e investigaciones ajenas publicadas anteriormente, pero resulta que la mayoría de los modelos IA más avanzados son meras cajas negras inexpugnables: no se explica su lógica interna, no se garantiza su funcionamiento ni su equidad y no se puede analizar el código fuente.

Muchos de los productos más populares, como ChatGPT o el moderno traductor SeamlessM4T de Meta, resultan tener esas indeseables características, aunque se anuncian como artículos de ciencia abierta.

DeepSeek no es código abierto

Algunos más recientes, como DeepSeek, intentan superar a la competencia permitiendo disponer del código compilado, pero eso no es código abierto, y no aporta avances para la investigación científica.

Es decir, a pesar de que DeepSeek se anuncia como “open source”, no permite acceder al codigo fuente, sino solo al binario (compilado). No se puede leer, entender, ni modificar. Por eso nadie puede mejorar ese programa. Solo es posible usarlo como cliente de la empresa, no como investigador en ciencias de la computación.

Ante ese panorama, la realidad es que la falta de transparencia y reproducibilidad de esos modelos informáticos obstaculiza el progreso científico y erosiona la confianza en la investigación en IA.

El ejemplo de Rosetta y AlphaFold 3

David Baker, Demis Hassabis y John M. Jumper recibieron el Premio Nobel de Química de 2024 por la predicción de la estructura de proteínas. El software Rosetta nació a finales del siglo XX como un pequeño proyecto en el laboratorio de David Baker, en la principal universidad pública del estado de Washington. El código fuente estaba escrito y distribuido en el lenguaje de alto nivel Fortran -que cualquier especialista puede leer, entender y modificar- y se centraba en la predicción ‘ab initio’ de la estructura de pequeñas proteínas.

Partiendo de esas ideas y usando las bases de datos sobre proteínas publicadas por la comunidad investigadora, la empresa Google DeepMind desarrolló un potente análisis estadístico de datos mediante su código IA AlphaFold y AlphaFold 2.

En mayo de 2024, DeepMind presentó su modelo AlphaFold 3 a través de un artículo de la revista ‘Nature’, que sorprendentemente permitió a DeepMind mantener el código del software no disponible, a pesar de su propia política editorial, que se enfoca en “poner rápidamente a disposición de los lectores materiales, datos, código y protocolos asociados sin calificaciones indebidas”.

AlphaFold tampoco es código abierto

Más de mil miembros de la comunidad científica especialista en el área firmaron una carta enviada a ‘Nature’ porque dicho artículo “no cumple las normas de la comunidad científica de ser utilizable, escalable y transparente”.

Seis meses después, DeepMind dejó disponible el código bajo una licencia Creative Commons restrictiva. Así todo, sus condiciones no cumplen la definición de “open source” de la OSI. DeepMind no publica los pesos (el resultado del entrenamiento de su red neuronal) del modelo. Para obtenerlos, hay que solicitárselos y es la propia empresa quien decide si los da o no en cada caso. Sin ellos, no es posible usar AlphaFold 3 para predecir estructura de proteínas.

Asimismo, prohíbe explícitamente el uso de los parámetros o resultados del modelo AlphaFold 3 para actividades comerciales, incluido el entrenamiento de modelos biomoleculares similares.

Ese enfoque intenta satisfacer en parte tanto las necesidades científicas como los intereses comerciales de la empresa, pero debe quedar claro que no nos encontramos ante un proceso de ciencia abierta. Un lastre para el avance del conocimiento científico, que pertenece a toda la humanidad.

![]()