La vida profesional de un científico, en especial sus contribuciones en forma de publicaciones en revistas científicas, se valora muchas veces “a peso”. Quiero decir que se valoran sus publicaciones contando el número de artículos publicados. Hay veces que esta medida “a peso” se matiza, valorando en qué tercio del Journal Citations Report (JCR) de cada año se encuentran las revistas en las que están publicados sus artículos. En una encuesta realizada de 2009 entre investigadores principales de proyectos financiados por el Fondo de Investigación Sanitaria (FIS) de España, una de las preguntas se relacionaba con el factor de impacto de las revistas científicas incluidas en el JCR en el que se situaba la media de las publicaciones realizadas. Esta valoración con el factor de impacto de las revistas como base para saber cómo situar al investigador en su campo científico es bastante errónea, porque ni un número alto de publicaciones es igual a una elevada calidad, ni que se publique en revistas con un factor de impacto elevado (del primer tercio de cada área) es equivalente a una mayor trascendencia o relevancia científica de lo publicado. Esto último viene a ser todavía más preocupante cuando hay diferentes estudios que reflejan el mismo resultado: que la mayoría de los artículos publicados en revistas de alto factor de impacto no reciben demasiadas citas en los trabajos de otros investigadores, y que cerca del 50% no reciben ninguna.

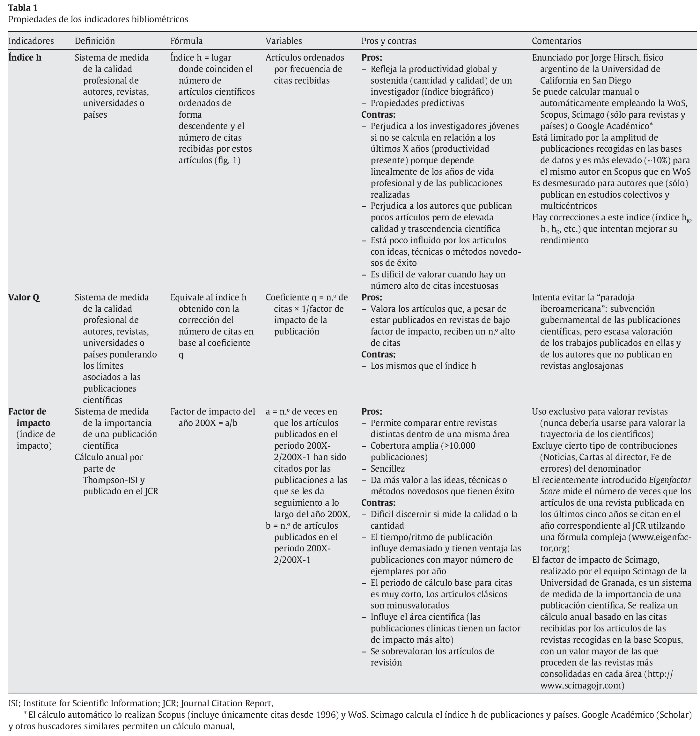

La propuesta de Jorge Hirsch de emplear el índice h ha permitido mejorar la evaluación de los investigadores porque es un indicador más estable de la importancia de las publicaciones al relacionarlas con las citas obtenidas por cada una de ellas. Aunque la definición de lo que significa el índice es un tanto barroca (“un científico tiene un índice h si el h de sus Np trabajos tiene al menos h citas cada uno y los otros Np-h trabajos no tiene más que h citas cada uno”), su cálculo y su esencia filosófica son sencillos. De hecho, las bases de pago Thomson-ISI Web of Science y Scopus permiten el cálculo automático del índice. Otras bases gratuitas, como a Google Académico, también lo permiten e incluso aportan un denominado índice h10 que define el número de publicaciones que han recibido 10 o más citas bibliográficas. En esencia, si decimos que un autor tiene un índice h de 25 queremos decir que ese autor tiene por lo menos 25 publicaciones que han sido citadas al menos 25 veces cada una de ellas. Este índice introduce una ordenación de las publicaciones de cada autor en relación al número de citas obtenidas, y en el valor en el que se cruzan el número de orden y el número de citas se establece el índice h.

Se han realizado bastantes estudios sobre la utilidad real y la aplicada de este índice en diferentes campos del conocimiento científico, y hay numerosos artículos de opinión sobre su valor, incluso predictivo, y cómo aplicarlo (ver Abellanas, Amin & Mabe, García, Imperial & Rodríguez-Navarro 1 y 2). Se ha resaltado su robustez, su estabilidad, que se incremente su valor y no disminuya a lo largo de la vida profesional, y que sea poco influido por factores que pueden alterar otros indicadores, como la presencia esporádica de determinados autores en estudios multicéntricos que reciben un número elevado de citas. Un artículo interesante es el del equipo Scimago, donde el índice h refleja las características y variaciones según el área científica de trabajo de científicos españoles de prestigio como Barbacid, Oro, Rodés, Soria o Zuazua (SCImago). Basándonos en algunos trabajos, como el de Salgado y Páez en el campo de la Psicología social, los índices h de los catedráticos y los sexenios obtenidos por estos no tienen una relación demasiado directa. El número de sexenios en España parece estar más asociado con la antigüedad como catedrático en la mayoría de los casos que con la calidad de la producción científica. También es llamativo que muchos de los catedráticos históricos de nuestro país tienen concedidos dos o menos sexenios de investigación aunque estos datos son dinámicos y mutables. Tal vez este hecho sea un matiz o característica española por la historia reciente de nuestro país, y no es extrapolable a otros países, o por lo menos no a los anglosajones y a la mayoría de los países del centro y norte de Europa, donde hay una asociación más estrecha entre cargos, puestos e índice h. Por desgracia, el índice h es poco conocido todavía en España y es sistemáticamente ignorado o desconocido para muchos de los científicos que deben realizar labores de evaluador en comités de contratación o de selección de proyectos para ser financiados por instituciones oficiales.

Hablar del índice h me hace recordar las animadas discusiones mantenidas durante muchos años con compañeros y amigos y, en especial las largas y chispeantes charlas con José Schneider Fontán y José Pontón San Emeterio, sobre si se debe valorar más un artículo científicamente consistente y avalado por numerosas citas de otros autores que ha sido publicado en una revista con pocos medios y menor repercusión internacional a priori (es decir, con un bajo factor de impacto). Mi opinión siempre ha sido que sí, que se debe valorar más porque se compite en desventaja desde el primer momento por múltiples razones históricas y estructurales de nuestro país que atravesó un largo desierto científico durante la dictadura, se acercó a los oasis de la excelencia en los últimos años pero que parece condenado, como Moisés, a volver y permanecer eternamente entre la aridez de la piedra y la arena, con las últimas acciones gubernamentales. Por eso, la repercusión obtenida por un artículo con un número de citas alto en una revista con un bajo factor de impacto debería valorarse más que un mismo número de citas obtenidas por un artículo publicado en una revista extranjera (sobre todo anglosajona) con mayor factor de impacto. Los autores que publican en revistas con factores de impacto menores de 2 sufren una penalización evidente y en estos parámetros se encuentran la mayoría de las revistas de nuestros países que, además, sufren la anteriormente denominada paradoja iberoamericana y el ouroboros de la poca visibilidad internacional.

Views: 0

Muchas gracias por los dos artículos que has incluido tras mi comentario. Son buenas clarificaciones que creo que aún me sirven más para reforzar mi impresión de que cualquiera de los actuales métodos de medida de calidad de la investigación son muy poco adecuados para los temas de investigación minoritarios. Comentas en tu artículo que las revistas nacionales en tu area difícilmente pueden tener un índice de impacto mayor que dos, por lo cual a quienes publican en ellas se les penaliza sistemáticamente. Los tres últimos artículos que hemos publicado los hemos enviado a las revistas internacionales de mayor índice de impacto de JCR, en las que la temática de cada articulo podía encajar. Los índices de impacto en este momento de estas revistas son: 3,357 (CORRSCI); 4,261 (SOLMAT) y 2,041 (energy and buildings). Y tienen estos índices de impacto porque en algún momento se convirtieron en referente de alguno de los campos de investigación “estrella”, como por ejemplo del desarrollo de materiales fotovoltáicos en el caso de la revisa SOLMAT. Podríamos incluso decir que “casi nos hacen el favor” de publicarnos artículos en temas minoritarios, no relacionados con su campo estrella. La verdad es que en estos campos tan minoritarios, donde prácticamente todos los investigadores a nivel mundial “nos conocemos”, me da la impresión de que ninguno de los métodos actualmente utilizados como medida de la calidad pueda servir como una indicación real de la misma. Posiblemente el número de patentes en explotación, o el de ponencias invitadas en congresos internacionales referentes en el área de investigación, o el de tesis doctorales dirigidas, o……. serían mejor indicación de la calidad. Claro que, emplear este tipo de indicadores supondría un revolución muy grande en nuestro sistema de evaluación de calidad, y además con total seguridad este método sólo sería válido para campos de investigación minoritarios. Como imagino que a estas alturas del texto tendrás mucha curiosidad acerca de qué campo hablo, se trata del desarrollo de almacenamiento térmico basado en materiales de cambio de fase.

Un saludo

Hola Ana,

Muchas gracias por tu interesante e informativo comentario. Veo que tu campo todavía es más minoritario que el mío, la Micología. Aunque nosotros tenemos la “suerte” de que nuestros trabajos pueden encajar en muchas otras áreas científicas de las que selecciona JCR (Microbiology, Infectious Diseases, etc.). De todas formas, lo que comentas es muy estimulante y estamos de acuerdo con que hay que valorar más cosas que las publicaciones. Con el tema de las patentes está claro que si son patentes que están en uso por empresas puedes buscar la forma de valorarlas objetivamente o casi. Con el tema de las ponencias habría más problemas porque en determinadas áreas los que trabajan en países como el nuestro están en muchas ocasiones ejerciendo ciertas endogamias y favoritismos de grupo o fratría. Me explico mejor, muchas ponencias invitadas son por amistad o por intereses comunes en nuestro país y en el resto de Europa, carezco de datos de EE.UU. Lo digo con conocimiento de causa porque he estado implicado en la organización de algunos congresos locales, nacionales e internacionales y he visto las presiones que hay por colocar a determinadas personas en mesas redondas, simposios y demás. También tengo la sensación de que es bueno abrir el debate y airear estos temas porque la transparencia se consigue muchas veces generando cierta polémica y, sobre todo, discusión. Atentamente. Guillermo

Muy bueno, pero solo una duda, el indice h, ¿No tiende a “subir solo” conforme pasa el tiempo?, o dicho de otra manera, en parte puede ser un indice de la edad del investigador. No obstante, un indice h alto en un investigador joven es muy significativo y demuestra su calidad.

Hola Ignacio.

Muchas gracias por tu comentario tan jugoso. En parte ocurre lo que tu dices pero además de años es necesario que los trabajos tengan repercusión y sean considerados suficientemente buenos para ser citados por otros autores que compartan interés científico. Cuanto más alto es el índice, más cuesta subirlo porque tienen que citarse más publicaciones de forma más o menos simultánea. La base se amplía y cuesta reunir más trabajos con igual número de citas.

Se han planteado muchas medidas correctoras para afinar más el índice h. Por ejemplo, calcular el índice h de los últimos 5 o 10 años (de esta forma se valora la actividad reciente y no se rebaja el valor de los jóvenes científicos), eliminar las autocitas o las citas de cortesía para el cálculo si estas pasan de un porcentaje considerado prudente (<10-15% de las citas recibidas), penalizar cuando las citas son mayoritariamente negativas… Algunas de estas correcciones son difíciles de realizar cuando son muchos los autores para evaluar pero serían asumibles en pruebas a las que se presentan un número bajo de candidatos (como en las oposiciones a plazas de profesores o investigadores, o en los procesos de acreditación de la ANECA, o en la evaluación de currículos de investigadores que solicitan subvención para sus proyectos).

Está claro que puede y debe mejorarse. También que no sirve para comparar el currículo investigador de autores de diferentes áreas científicas ya que las condiciones no son las mismas y hay áreas con diferentes ritmos de generación de conocimiento y magnitud de las publicaciones. En este campo, por suerte o por desgracia, hay mucho camino que recorrer para llegar a Ítaca.

Un abrazo