|

|

La UPV/EHU tiene licencia corporativa de este software del que en los próximos días se va a impartir un curso online de 4 sesiones y un seminario técnico en Madrid.

Curso online de 4 sesiones

No gratuito.

11 de Marzo al 14 de Marzo de 9:00 a 13:00.

8 de Abril al 11 de Abril de 9:00 a 13:00.

13 de Mayo al 16 de Mayo de 9:00 a 13:00.

Dirigido a nuevos usuarios del programa o de CFD en general o como curso de refresco para usuarios ocasionales. Los alumnos aprenderan de forma ordenada y estructurada los fundamentos desarrollados en STAR-CCM+. Se pretende que los alumnos tras cada día puedan realizar sus propias simulaciones a traves de los tutoriales y lecciones.

Página web del curso aquí.

Seminario técnico: Interacción fluido estructura y co-simulación

Gratuito pero plazas limitadas.

El día 10 de Abril de 10:00 a 16:00 se realizará en Madrid el seminario técnico gratuito “Introducción a las simulaciones de interacción fluido estructura (FSI)”. Se tratarán los diferentes aspectos relacionados con la co-simulación y la importancia de la solución conjunta, con ejemplos concretos, validaciones y “best-practices”.

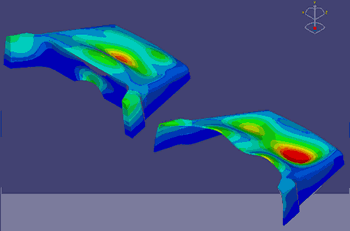

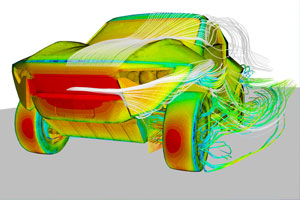

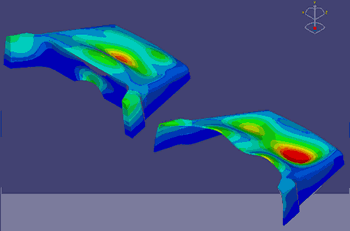

CFD simulation En particular, se mostraran simulaciones con cargas dinámicas, cómo definir las condiciones al contorno para un análisis de “flutter” y el movimiento de estructuras en campos fluidos con 6 grados de libertad.

Página web del curso aquí.

Más información

Página web de formación de CD-Adapco, aquí.

.

El Servicio General de Informática Aplicada a la Investigación (Cálculo Científico) ha renovado la licencia corporativa para la UPV/EHU del programa de dinámica de fluidos (CFD) STARCCM+ para el año 2014.

Estas licencias pueden usarse en los clusters de cálculo del Servicio de Cálculo Científico de la UPV/EHU. También pueden solicitarse licencias personales para uso en los ordenadores de los investigadores, para ello es necesario realizar una solicitud a los técnicos del Servicio de Cálculo Científico.

Características de la licencia

La licencia será valiada para un año y permite el uso de todos los procesadores del ordenador. La licencia se puede usar en ordenadores corporativos de la UPV/EHU o a través de VPN.

Se dispone de licencia de docencia que permite la instalación de STARCCM+ en las aulas de docencia de la UPV/EHU para impartir cursos y asignaturas.

Tarifa

El uso de STARCCM+ en aulas para docencia de cursos y asignaturas es gratuito.

El uso de STARCCM+ en el cluster de cálculo Arina de la UPV/EHU es gratuito y solo se factura el uso de horas de cálculo según la tarifa estándar del Servicio.

Las tarifas que se aplicarán para la instalación de licencias en los ordenadores personales de los investigadores se detalla a continuación.

- Para un PC y menos de 100 horas.

Se pueden solicitar licencias gratuitas para probar el programa, realizar tareas relacionadas con la docencia o proyectos de fin de master. Estas licencias estarán restringidas a PCs y tendrán de un máximo de 100 horas de uso. No se dará acceso por VPN.

Las licencias destinadas a su instalación en ordenadores corporativos personales cuyo uso va a ser de más de 100 horas se facturará a 140 € por equipo, si el equipo es portátil se podrá solicitar acceso por VPN. Si se tratase de acceso VPN usando otro equipo diferente habrá que solicitar una licencia para éste.

- Estaciones de trabajo y servidores.

Las licencias destinadas a su instalación en estaciones de trabajo y servidores tendrá un coste de 45 € por core.

Más información Más información

- Página web CD-Adapco, porveedor del software.

.

Ikerbasque ha lanzado una nueva convocatoria internacional para fortalecer la investigación científica en Euskadi. Los investigadores de Ikerbasque pueden usar las máquinas y servicios del Servicio de Informática Aplicada a la Investigación (Cálculo Zientífico) IZO-SGI. De hecho muchos investigadores Ikerbasque son usuarios del IZO-SGI. Ikerbasque ha lanzado una nueva convocatoria internacional para fortalecer la investigación científica en Euskadi. Los investigadores de Ikerbasque pueden usar las máquinas y servicios del Servicio de Informática Aplicada a la Investigación (Cálculo Zientífico) IZO-SGI. De hecho muchos investigadores Ikerbasque son usuarios del IZO-SGI.

Oferta y condiciones de la convocatoría

- 25 contratos para investigadores como Ikerbasque Research Fellows.

- Contratos de 5 años de duración.

- Dirigido a personas doctoradas entre enero de 2004 y diciembre de 2011.

- Se requiere carta de aceptación del centro de acogida.

- Fecha límite solicitud: 31 de marzo de 2014 a las 13:00.

Más información

Página web de Ikerbasque: www.ikerbasque.net

Ikerbasque-k Euskadin ikerketa zientifikoa sustatzeko xedez nazioarteko deialdi berribat martxan jarri duela jakinarazten dizu. Ikerbasqueko ikerlariek Ikerkuntzari Zuzendutako Informatikako Zerbitzu Orokorra (Kalkulu Zientifikoa) IZO-SGI-k dituen makinak eta zerbitzuak erabili ditzakete beraien atxikipen zentroaren bitartez. Izan ere, IZO-SGI-ko erabiltzaileetako asko Ikerbasque ikerlariak dira. Ikerbasque-k Euskadin ikerketa zientifikoa sustatzeko xedez nazioarteko deialdi berribat martxan jarri duela jakinarazten dizu. Ikerbasqueko ikerlariek Ikerkuntzari Zuzendutako Informatikako Zerbitzu Orokorra (Kalkulu Zientifikoa) IZO-SGI-k dituen makinak eta zerbitzuak erabili ditzakete beraien atxikipen zentroaren bitartez. Izan ere, IZO-SGI-ko erabiltzaileetako asko Ikerbasque ikerlariak dira.

Deialdiko eskaintza eta baldintzak

- 25 kontratu Ikertzaileentzat Ikerbasque Research Fellows bezala.

- 5 urteko kontratuak.

- Doktoradutza titulua 2004ko urtarrila eta 2011ko abenduaren artean lortu duten ikerlariei zuzenduta.

- Atxikipen Zentroaren onarpen gutuna ezinbestekoa da.

- Epemuga: Martxoak 31, 13:00-tan.

Informazio gehiago

Ikerbasque web orrialdea: www.ikerbasque.net

La supercomputación o computación de altas prestaciones (High Performance Computing -HPC- en Ingles) utiliza computadoras de altas prestaciones y gran potencia para realizar operaciones matemáticas que de otro modo serían muy pesadas (o imposibles) de ejecutar. A finales de Noviembre se actualizó la lista de los ordenadores más potentes del mundo (top500.org) que es una referencia en el campo de la supercomputación. Cogamos de esta lista como ejemplo el supercomputador Teide instalado en la Islas Canarias y analizemos sus características: vemos que ocupa el puesto 138 de la lista y tiene una capacidad de 340 TFlops, es decir puede realizar 340.000.000.000.000 operaciones por segundo. Para entender mejor este número, cojamos el Camp Nou y llenémoslo de personas (cabrían 98.787 personas). Si a cada una de ellas le damos una calculadora, y suponemos que pueden realizar una operación por segundo, ¡¡¡necesitarían de 110 años para realizar el mismo número de operaciones que realiza el Teide en 1 segundo!!! En este ejemplo creemos que se aprecia claramente la potencia de este tipo de infraestructuras, pero si lo comparáramos con el ordenador que esta en el número 1 de la lista top500 Tianhe-2 (MilkyWay-2) las personas del Camp Nou necesitarían 17.000 años, y si lo comparamos con infraestructuras más modestas como la nuestra, el cluster Arina, en este caso se necesitarían 3 años para realizar el número de operaciones que puede hacer Arina por segundo.

Vista la gran capacidad de cálculo de estas herramientas, a muchas personas le surge la pregunta, ¿para qué toda ésta potencia? Para ello, la organización sin animo de lucro norteamericana “Council on Competitiveness” ha elaborado un vídeo para enseñar y promover las bondades del HPC.

[youtube]http://www.youtube.com/watch?v=brwSYZQM5hc#t=57[/youtube]

En el video, en modo general se muestran las aplicaciones más espectaculares que pudiera tener el HPC:

- Programa Espacial y Aeronáutico: Aerodinámica, ventilación de las cabinas, desarrollo de los motores/propulsores …

- Industria del gas y petroleo: estudio de las propiedades geológicas del suelo para abaratar la explotación

- Desarrollo de energías renovables

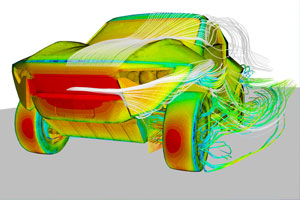

- Automoción: Desarrollo de motores más eficientes, reducción de contaminación, seguridad, propiedades de materiales, confort del pasajero, …

- Desarrollo de productos de uso cotidiano: mejoras de diseño (para ahorrar espacio, estética …), agilizar los tiempos para lanzar nuevos productos al mercado

- Estudio de fenómenos naturales para comprenderlos mejor y reducir sus posibles daños.

- Rendimiento deportivo

- Industria del entretenimiento: Animaciones y efectos especiales más realistas/espectaculares.

- Medicina: Desarrollo de nuevos tratamientos, prever la evolución de epidemias, nuevos fármacos …

Resumiendo, en el vídeo promocional se subraya la importancia del HPC, terminando con la frase “High performance computing means High performance business and High Performance Lifes” es decir, la computación de Altas prestaciones significa negocio de altas prestaciones y vida de altas prestaciones. Con palabras más sencillas podríamos decir que es una potente herramienta para conseguir una vida mejor para las personas.

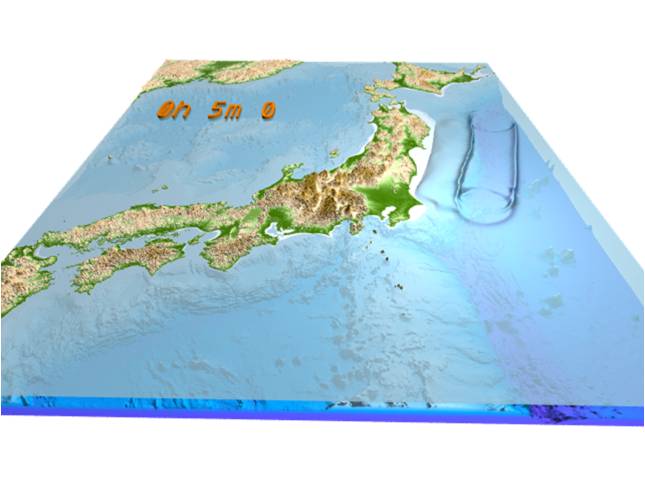

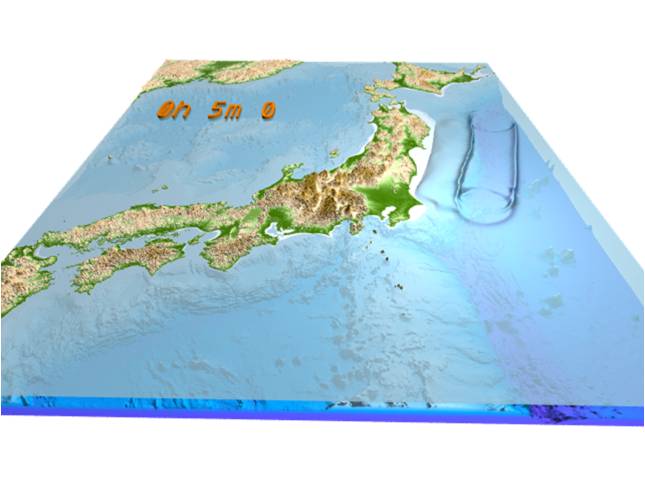

Como hemos visto, en este vídeo se muestran algunas de las aplicaciones más espectaculares del HPC, y relacionadas con éstas, en un evento reciente de HPC se subrayó varias veces el impulso que Japón había dado al HPC a raíz del terremoto de Tohoku y el tsunami que este causó en Marzo del 2011. En el evento se mostraron varios vídeos espectaculares mostrando los resultados de varios trabajos realizado en el supercomputador K (que fue el primero de la lista top500 justo varios meses después del terremoto/tsunami, Noviembre del 2011). Unos estudios se centraban en analizar el impacto del tsunami en la costa japonesa para en un futuro poder reducir las destrucción que otra ola similar pudiera causar, y otros modelizaban/simulaban el proceso de evacuación de la población y posibles mejoras de los protocolos para también reducir las consecuencias de fenómenos naturales parecidos.

- Tsunami que se creo a consecuencia del terremoto de Tohoku el 11-03-2012. Fuente: “Earthquake Research Institute, University of Tokyo, Prof. Takashi Furumura and Project Researcher Takuto Maeda. La animación completa se puede ver aquí. Más Información: 201103 Tohoku .

En el servicio de HPC del que dispone la UPV/EHU se realizan algunos proyectos pueden tener similitudes con los arriba mencionados, pero mayoritariamente, los investigadores de la UPV/EHU utilizan el HPC para investigación básica, y no tan aplicada como muchos de los ejemplos anteriores. En próximos posts intentaremos mostrar que es lo que hacen los usuarios de HPC de nuestro servicio.

1 The Council on Competitiveness: Es una entidad Norteamericana fundada en 1986. Es una organización no gubernamental y no partidista, que impulsa la competitividad América. Sus miembros son ejecutivos de varias empresas, rectores de universidad, directores de laboratorios nacionales … y su principal objetivo es impulsar la competitividad americana.

Los días 1 y 2 de Febrero se organizará en Bruselas el FOSDEM 2014, un evento que ofrece a la comunidad del software libre un espacio para reunirse, compartir ideas y colaborar. FOSDEM es un evento no comercial organizado por la comunidad y para la comunidad, no es necesario registrarse.

FOSDEM es una conferencia muy concurrida con más de 478 conferenciantes y 504 sesiones organizadas en 44 temas para los más de 5000 asistentes. Entre los diferentes temas podemos encontrar:

y hasta 44 temas relacionados con diferentes lenguajes, áreas, sistemas, etc.

Más información

Página principal FOSDEM-2014

Agenda

Resumen de sesiones por día

Xabier López, profesor de Química Física de la UPV/EHU. ofrecerá una charla-coloquio sobre el Premio Nobel de Química de 2013 el 22 de enero, a partir de las 19:00, en AlhóndigaBilbao. Además la charla se retransmitirá en directo por eitb.com.

Resumen

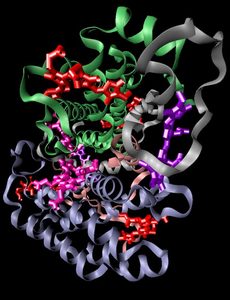

Proteina El Premio Nobel de Química 2013 ha recaído en Martin Karplus, Michael Levitt y Arieh Warshel por su trabajo de desarrollo de modelos computacionales para tratar sistemas químicos complejos. Gracias a estos investigadores estamos más cerca del viejo sueño de Newton de describir la complejidad aparente de la naturaleza a partir de unas pocas leyes matemáticas universales. Con las herramientas que nos aportan la física newtoniana y la física cuántica, vivimos el inicio de una nueva era en la que podremos simular la biología a través de ordenadores. Esta revolución ya ha ayudado en el diseño de fármacos y en el planteamiento de la química y la bioquímica como un problema matemático. En la próxima Zientziateka describiremos en qué consisten estas teorías, cómo han cambiado nuestra visión de qué es la química y por qué todo ello ha merecido un premio Nobel.

Esta conferencia se enmarca dentro de la iniciativa Zientziateka, que organizan mensualmente la Cátedra de Cultura Científica de la UPV/EHU y AlhóndigaBilbao para divulgar asuntos científicos de actualidad.

Más información

EITB divulgación.

El seminario gratuito ilustrará las ventajas técnicas que se pueden obtener mediante la simulación numérica 3D para el diseño y la optimización de productos de los principales sectores industriales y sujetos a fenómenos térmicos. El seminario incluye unas demostraciones en directo de cómo realizar mediante STAR-CCM+ el flujo entero de trabajo, desde la geometría CAD hasta la obtención de resultados cualitativos (imágenes 3D) y cuantitativos (números, tablas, reports).

La UPV/EHU posee licencia corporativa de este software a través del Servicio de Informática Aplicada a la Investigación (Cálculo Científico).

21 de febrero 2014, Madrid. Melia Galgos, Claudio Coello, 139, 28006

El seminario es gratuito pero las plazas son limitadas.

Programa

| 10:00 – 10:30 |

Llegada de los participantes, registro. |

| 10:30 – 13:00 |

Introducción, descripción de los modelos para el intercambio de calor, ejemplos concretos. |

| 13:00 – 14:30 |

Refresco, intercambio de ideas. |

| 14:30 – 16:00 |

Demostraciones con STAR-CCM+ de todo el flujo de trabajo, informaciones para la optimización y el cálculo en paralelo. |

Más información y registro

http://www2.cd-adapco.com/l/14592/2014-01-07/5zsd5

Regla mnemotécnica

export: Exportar (en ingles) al entorno

Variables de entorno

Las llamadas variables de entorno se definen a nivel de sistema operativo para el correcto o mejor funcionamiento del mismo. Muchas de ellas son predefinidas pero cada usuario puede definir también sus propias variables para su entorno. El funcionamiento de las variables de entorno es el mismo que las variables normales. Se suelen diferenciar usando normalmente letras mayúsculas para definirlas.

El comando export

El comando export es el que nos permite crear o modificar variables de entorno. Así

export VARIABLE-NAME

nos exporta VARIABLE-NAME o

export VARIABLE-NAME=valor

nos define y exporta VARIABLE-NAME como variable en entorno al mismo tiempo que el asigna un valor. Si no usásemos el comando export, VARIABLE-NAME se mantendría como una variable normal.

Ejemplos

| USER |

Contine el nombre del usuario. |

| HOSTNAME |

Contine el nombre de la máquina. |

| HOME |

Indica cual es el directorio home del usuario. |

| PATH |

Contine los lugareres o paths del sistema donde se buscarán programas y comandos. |

| SHELL |

Indica cual es el intérprete de comando que se esta usando. |

Es importante por ejemplo la variable PATH que nos dice donde se encuentran comandos tipo ls, cp, if, etc para su ejecución. Podemos mostrar su valor con

$ echo $PATH

Como veis cada path diferente viene separado por “:“. Podemos modificarla para que busque comandos y programas en la carpeta bin de nuestro home, donde podremos poner nuestros propios programas y scripts para poder ejecutarlos fácilmente desde cualquier directorio sin necesidad de copiarlos.

$ PATH=$PATH:$HOME/bin

$ export PATH

$ #Que es equivalente a ejecutar directamente

$ export PATH=$PATH:$HOME/bin

$ echo $PATH

Como veis hemos añadido al final a la variable PATH la carpeta $HOME/bin, y hemos usado la variable de entorno $HOME. Hay que tener cuidado de añadir y no sustituir con:

$ export PATH=$HOME/bin

$ echo $PATH

donde el comando echo no funcionará pues nuestro PATH será únicamente $HOME/bin, no puede ejecutar el comando echo ni ningún otro porque no va a buscar comandos a ningún otro sitio. Lo más sano en este caso es cerrar la terminal y abrir otra.

El incesante crecimiento de la potencia de cálculo de los ordenadores ha hecho que se quede atrás la barrera del PetaFLOPS de potencia. Hoy en día los expertos tratan de vislumbrar cuales son las tecnologías que permitirán llegar al hito del ExaFLOPS y desarrollarlas. No obstante, es muy probable que sea algo totalmente diferente a lo que hoy estamos acostumbrados y a lo que la mayoría puede imaginar.

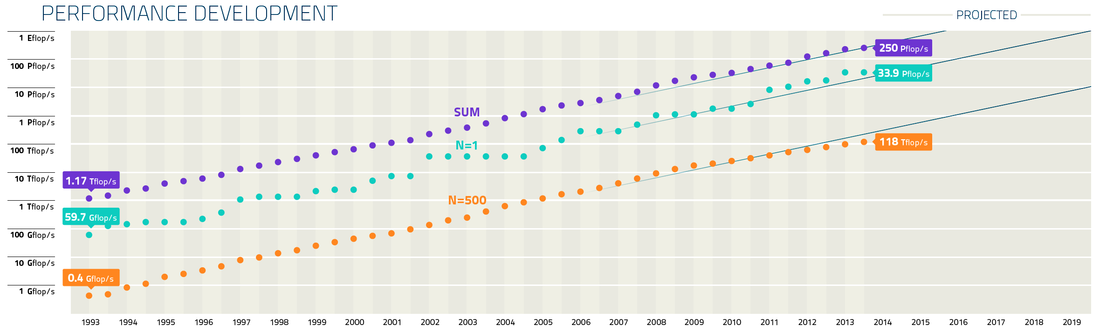

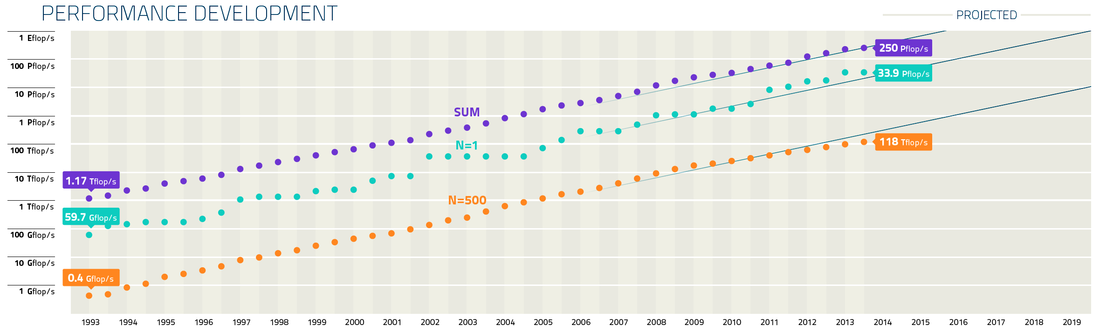

Potencial del superordenador más potente (N=1) del top500.org, el 500 de la lista (N=500), y la suma de la potencia de toda la lista (SUM). El incremento exponencial de la potencia de los ordenadores es una constante desde su invención. Esta tendencia está relacionada con la conocida Ley de Moore. Es más, como vimos en la entrada “La Ley de Kurzweil, una extensión de la ley de Moore”, el incremento exponencial de las máquinas de cálculo es una hecho desde principios del siglo XX. Si nos restringimos a la era moderna de los supercomputadores y a la lista top500.org, que lleva usando la misma métrica (el benchmark LINAPCK) desde que se publicó por primera vez en 1993, tenemos que el ordenador más potente del mundo en 1993 era el CM-5 construido por Thinking Machines Corporation e instalado en el Laboratorio Nacional de Los Alamos (EEUU) con 60 GigaFLOPS (10⁹ FLOPS). En 1997 ASCI Red de Intel e instalado en los Laboratorios Nacionales Sandia (EEUU) alcanzó los 1.1 TeraFLOPS (10¹² FLOPS). 11 años despues, en 2008, el Roadrunner de IBM instalado nuevamente en el laboratorio de Los Alamos alcanza el PetaFLOPS (10¹⁵ FLOPS), 1000 veces más potente que ASCI Red. Recientemente en el 2013 Tianhe-2 instalado en el National University of Defense Technology (China) alcanzó los 34 PetaFLOPS. Es por ello que se espera alcanzar el ExaFLOPS (10¹⁸ FLOPS) a principios de la década de 2020.

Si observamos las tecnologías de estos equipos, vemos que en 1993 el superordenador más potente era un ordenador vectorial. ASCI Red (1997) por el contrario era un ordenador formado por nodos escalares y la tecnología vectorial pasó a ser residual a partir de esa época. Roadrunner en 2008 fue adelantado a su tiempo pues ya utilizó procesadores gráficos (procesadores Cell de la Play Station) como coprocesador matemático para incrementar la potencia de cálculo de los nodos. Este tipo de arquitectura se ha generalizado a partir de 2010 entre los superordenadores más potentes gracias al diseño o adecuación de los dispositivos de coprocesamiento para cálculo. No obstante el procesamiento escalar y paralelo aun perdura como demuestran los top 1 K Computer y Sequoia. Como podemos observar las arquitecturas que se usaron para romper la barreras del Giga, el Tera o el PetaFLOPS son diferentes.

Una vez superada con creces la barrera del PetaFLOPS, los expertos están poniendo ya su meta en el ExaFLOPS y están tratando de diseñar la tecnología que permitirá alcanzar esa barrera que necesitará de alguna nueva tecnología disruptiva, pues la evolución lineal de las tecnologías actuales no permite alcanzar ese objetivo. Por supuesto, no se trata sólamente de diseñar un superordenador para superar el hito del ExaFLOPS, sino de desarrollar la tecnología que se usarán los superordenadores en ese momento y puede que los ordenadores más modestos en un futuro más lejano si la tecnología es transferible a estos.

Como ejemplo, entre los problemas a los que se enfrentan los investigadores el principal que encontramos es el del consumo eléctrico. En una evolución lineal de la tecnología actual un superordenador con capacidad de ExaFLOPS dentro de unos 10 años consumiría unos 200 MegaWatios, una cantidad de energía inasumible con un coste anual de entre 200 y 300 millones de $ anuales.

Otro problema es que el ancho de banda a memoria no crece al ritmo al que crece la capacidad de computación, por lo que podríamos, en teoría, llegar a tener procesadores que tendrían que quedarse esperando porque no se les puede alimentar de datos a la velocidad necesaria para que estén constantemente computando. Este factor, de hecho, se dio en las primeras versiones de los procesadores Xeon. Otro dato interesante relacionado con el punto anterior es que hoy en día cuesta más energía mover dos datos de la memoria al procesador que luego procesarlos.

Otro problema viene por el hecho de que los supercomputadores de la próxima década tendrán tal cantidad de procesadores que la programación tendrá que evolucionar para poder ejecutar los códigos en esa ingente cantidad de procesadores de forma eficiente, reduciendo la necesidad de comunicarse entre los procesadores o con nuevas formas de hacerlo de forma eficiente. Al igual que sucede con el acceso a memoria, han de pasar la mayor parte del tiempo calculando y no enviando o esperando información (datos o resultados) de otros procesadores. De hecho, hoy en día los centros que diseñan e instalan superordenadores tienen proyectos paralelos para el desarrollo y evolución de programas de cálculo, seleccionados por su relevancia científica, para optimizarlo y adecuarlos a los supercomputadores. Evidentemente cualquier programa no es capaz de usar eficientemente cientos de miles de cores.

La computación a escala del ExaFLOPS es un reto científico y tecnológico que dotará a la Ciencia de las herramientas para el desarrollo de los programas de investigación frontera del momento y sentará las bases de futuras tecnologías en el área general de la computación de altas prestaciones. Es por ello un programa estratégico dentro de la I+D de los países que necesita de proyectos a largo plazo y fuerte financiación para su desarrollo. China con su fuerte incursión en supercomputación esta década con tecnología propia. El gobierno de Japón, junto con Fujitsu, han desarrollado del Supercomputador K han sentado las bases para continuar con la supercomputación, de tradición en el país, y alcanzar el EXAPLOPs. En Europa se lanzó en 2011 el proyecto MontBlanc para desarrollar la computación a Exaescala con partners como las firmas europeas Bull y Arm. En EEUU se ha remitido reciente un informe al Congreso para el diseñar la estrategia hacia la computación a Exaescala que permita a EEUU desarrollar esta tecnología donde tienen mucho que aportar las grandes fuertes firmas de la computación estadounidenses. En este informe se detallan los mayores retos del proyecto y se señala que sin financiación ni liderazgo público está no se podrá llevar a cabo.

|

|

Comentarios